全套服務(在線�、面授均享)

1�����、面授+遠程+錄播

2���、24小時遠程真機練習

3�、行業(yè)專家講師親臨授課

4、每班一名班主任督學

5����、一年半免費重聽學習

學習如何使用Hadoop生態(tài)系統(tǒng)關鍵性技術來導入并處理數據�。

在為期4天的培訓中���,學員將學習關鍵概念和掌握使用新技術和工具將數據采集到Hadoop集群并進行處理。通過學習掌握諸如Spark(包括SparkStreaming和SparkSQL)��、Flume、Kafka以及Sqoop這樣的Hadoop生態(tài)系統(tǒng)工具和技術�����,Hadoop開發(fā)員將具備解決實際大數據問題和挑戰(zhàn)的能力���。使用Spark,不同行業(yè)的開發(fā)人員可以為不同的商業(yè)應用和系統(tǒng)架構編寫復雜的并行應用���,得以更快速地獲取更優(yōu)的商業(yè)決策��,幫助決策人員進行及時應對��。

一.培訓內容

● 通過講師在課堂上的講解,以及實操練習�,學員將學習以下內容:

● 在Hadoop集群上進行分布式存儲和處理數據。

● 通過在Hadoop集群上編寫�����、配置和部署ApacheSpark應用����。

● 使用Sparkshell進行交互式數據分析���。

● 使用SparkSQL查詢處理結構化數據。

● 使用SparkStreaming處理流式數據�。

● 使用Flume和Kafka為SparkStreaming采集流式數據�����。

二.培訓對象及學員基礎

● 本課程適合于具有編程經驗的開發(fā)員及工程師���。無需ApacheHadoop基礎���。

● 培訓內容中對ApacheSpark的介紹所涉及的代碼及練習使用Scala和Python�,因此需至少掌握這兩個編程語言中的一種。

● 需熟練掌握Linux命令行�。

● 對SQL有基本了解。

三.課程大綱

1. Hadoop及生態(tài)系統(tǒng)介紹

● ApacheHadoop概述

● 數據存儲和攝取

● 數據處理

● 數據分析和探索

● 其他生態(tài)系統(tǒng)工具

● 練習環(huán)境及分析應用場景介紹

2. ApacheHadoop文件存儲

● 傳統(tǒng)大規(guī)模系統(tǒng)的問題

● HDFS體系結構

● 使用HDFS

● ApacheHadoop文件格式

3. ApacheHadoop集群上的數據處理

● YARN體系結構

● 使用YARN

4. 使用ApacheSqoop導入關系數據

● Sqoop簡介

● 數據導入

● 導入的文件選項

● 數據導出

5. ApacheSpark基礎

● 什么是ApacheSpark

● 使用SparkShell

● RDDs(可恢復的分布式數據集)

● Spark里的函數式編程

6. SparkRDD

● 創(chuàng)建RDD

● 其他一般性RDD操作

7. 使用鍵值對RDD

● 鍵值對RDD

● MapReduce

● 其他鍵值對RDD操作

8. 編寫和運行ApacheSpark應用

● Spark應用對比SparkShell

● 創(chuàng)建SparkContext

● 創(chuàng)建Spark應用(Scala和Java)

● 運行Spark應用

● Spark應用WebUI

9. 配置ApacheSpark應用

● 配置Spark屬性

● 運行日志

10. ApacheSpark的并行處理

● 回顧:集群環(huán)境里的Spark

● RDD分區(qū)

● 基于文件RDD的分區(qū)

● HDFS和本地化數據

● 執(zhí)行并行操作

● 執(zhí)行階段及任務

11. Spark持久化

● RDD演變族譜

● RDD持久化簡介

● 分布式持久化

12. ApacheSpark數據處理的常見模式

● 常見Spark應用案例

● 迭代式算法

● 機器學習

● 例子:K-Means

13. DataFrames和SparkSQL

● ApacheSparkSQL和SQLContext

● 創(chuàng)建DataFrames

● 變更及查詢DataFrames

● 保存DataFrames

● DataFrames和RDD

● SparkSQL對比Impala和Hive-on-Spark

● Spark2.x版本上的ApacheSparkSQL

14. ApacheKafka

● 什么是ApacheKafka

● ApacheKafka概述

● 如何擴展ApacheKafka

● ApacheKafka集群架構

● ApacheKafka命令行工具

15. 使用ApacheFlume采集實時數據

● 什么是ApacheFlume

● Flume基本體系結構

● Flume源

● Flume槽

● Flume通道

● Flume配置

16. 集成ApacheFlume和ApacheKafka

● 概要

● 應用案例

● 配置

17. ApacheSparkStreaming:DStreams介紹

● ApacheSparkStreaming概述

● 例子:Streaming訪問計數

● DStreams

● 開發(fā)Streaming應用

18. ApacheSparkStreaming:批處理

● 批處理操作

● 時間分片

● 狀態(tài)操作

● 滑動窗口操作

19. ApacheSparkStreaming:數據源

● Streaming數據源概述

● ApacheFlume和ApacheKafka數據源

● 例子:使用Direct模式連接Kafka數據源

20. 結論

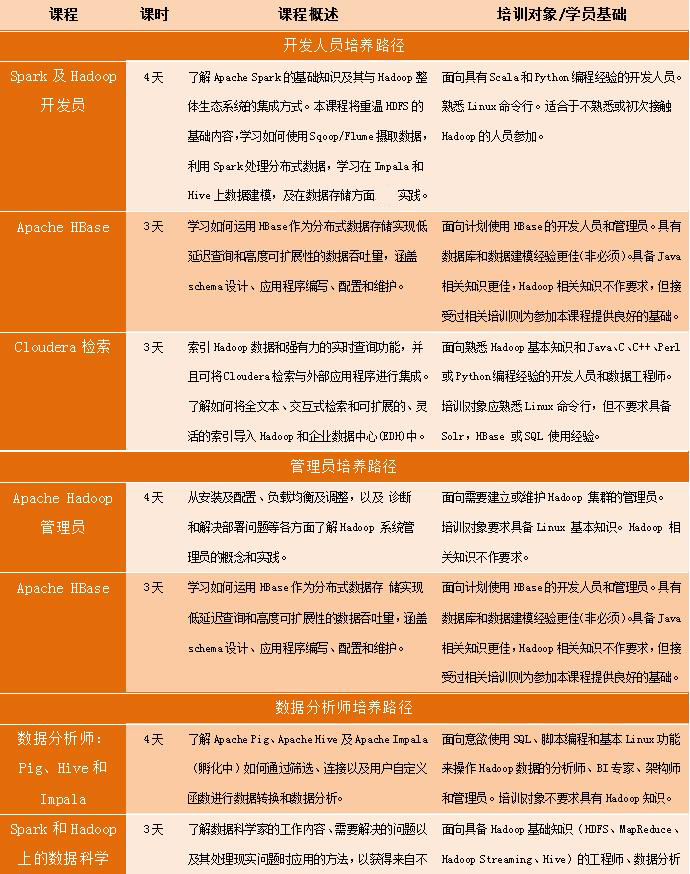

Cloudera大數據課程體系